Σύστημα τεχνητής νοημοσύνης "προβλέπει" τους εγκληματίες με βάση τα χαρακτηριστικά του προσώπου τους

Αμφιλεγόμενη μελέτη υποστηρίζει πως είναι δυνατό να διακρίνει τους εγκληματίες με βάση ορισμένα ιδιαίτερα χαρακτηριστικά του προσώπου

Ερευνητές στην Κίνα δημιούργησαν ένα αυτοματοποιημένο σύστημα, το οποίο, όπως ισχυρίζονται, μπορεί να κρίνει εάν ένα άτομο είναι εγκληματίας, μόνο από τα χαρακτηριστικά του προσώπου του.

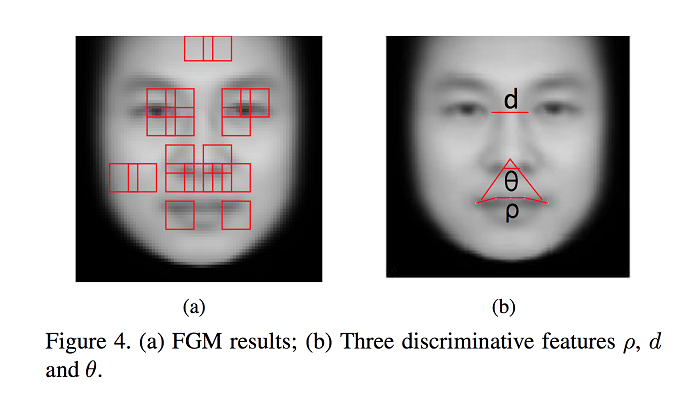

Το σύστημα τεχνητής νοημοσύνης, το οποίο δημιουργήθηκε στο Shanghai Jiao Tong University, κατάφερε, σύμφωνα με την έρευνα, να εντοπίσει τους εγκληματίες σε μία συλλογή 186 φωτογραφιών με ποσοστά επιτυχίας κοντά στο 90%, αξιολογώντας στοιχεία σχετικά με τα μάτια, τη μύτη και το στόμα τους.

Πώς λειτουργεί

Το σύστημα, το οποίο παραπέμπει σε ταινίες επιστημονικής φαντασίας, φέρνει στο προσκήνιο το ζήτημα της ύπαρξης ή μη ιδιαίτερων χαρακτηριστικών του προσώπου, τα οποία μπορούν να «προδώσουν» τους εγκληματίες.

Σύμφωνα με ορισμένες θεωρίες, οι οποίες έχουν ελεγχθεί ως προς την εγκυρότητά τους, οι εγκληματίες διαθέτουν κάποια συγκεκριμένα χαρακτηριστικά, ως προς την καμπυλότητα των χειλιών, τις αποστάσεις στα μάτια και τη λεγόμενη γωνία μύτης-στόματος.

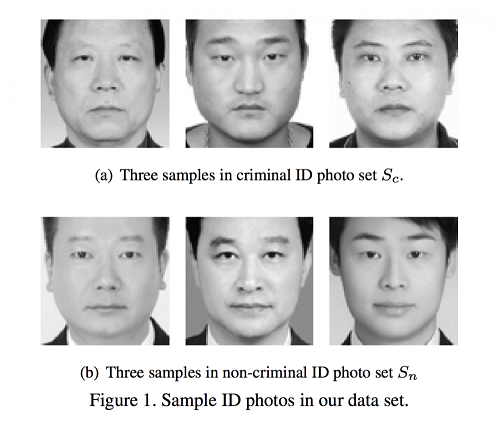

Στο πλαίσιο της έρευνας, οι ερευνητές Xiaolin Wu και Xi Zhang εκπαίδευσαν την τεχνητή νοημοσύνη με περίπου 1.670 εικόνες Κινέζων ανδρών, οι μισοί από τους οποίους ήταν καταδικασμένοι για διάφορα εγκλήματα.

Οι εικόνες που αναλύθηκαν είχαν ληφθεί από τις ταυτότητές τους, στις οποίες οι άνδρες, ηλικίας 18 έως 55 ετών, ήταν ξυρισμένοι και με ουδέτερη πόζα.

Έχοντας εκπαιδεύσει το σύστημα, ο Wu και ο Xiang προσέθεσαν 186 επιπλέον φωτογραφίες και ζήτησαν να ταξινομηθούν σε εγκληματίες και μη-εγκληματίες.

Η ακρίβεια των αποτελεσμάτων οδήγησε τους ερευνητές να ισχυρίζονται πως, «παρά τη σχετική ιστορική διαμάχη», οι άνθρωποι με ροπή προς την εγκληματικότητα έχουν πράγματι ορισμένα ιδιαίτερα χαρακτηριστικά προσώπου.

«Τα πρόσωπα των νομοταγών πολιτών έχουν μεγαλύτερο βαθμό ομοιότητας μεταξύ τους σε σχέση με τα πρόσωπα των εγκληματιών, ή οι εγκληματίες έχουν υψηλότερο βαθμό ανομοιότητας στην εμφάνιση του προσώπου τους σε σχέση με τους “μη-εγκληματίες" ανθρώπους», υποστηρίζουν οι Wu και Xiang.

Όπως επισημαίνει η ομάδα των επιστημόνων, απαιτείται περαιτέρω έρευνα προκειμένου να καλυφθούν τα χαρακτηριστικά από περισσότερες διαφορετικές φυλές, φύλα αλλά και εκφράσεις του προσώπου, προτού μπορέσει το σύστημα να χρησιμοποιηθεί σε μεγαλύτερη κλίμακα.

Η νέα "οργουελική" Κίνα

Το εξαιρετικά αμφιλεγόμενο σύστημα τεχνητής νοημοσύνης εγείρει φόβους ότι η Κίνα θα μπορούσε να προσθέσει τις εν λόγω πληροφορίες στις ήδη υπάρχουσες δυνατότητες εποπτείας των πολιτών της, η οποία περιλαμβάνει έναν φάκελο για σχεδόν κάθε έναν από αυτούς (dang'an).

Τα αρχεία, τα οποία συλλέγονται από την εποχή του Μάο, περιέχουν προσωπικές και εμπιστευτικές πληροφορίες, όπως τους ιατρικούς φακέλους και τις εκθέσεις του σχολείου του κάθε πολίτη.

Αξίζει να σημειωθεί ότι στον γιγαντιαίο μηχανισμό ασφαλείας της Κίνας περιλαμβάνονται ήδη συστήματα τεχνητής νοημοσύνης με σκοπό την "προληπτική αστυνόμευση".

Πριν λίγους μήνες, η κυβέρνηση της Κίνας ανέθεσε την China Electronics Technology Group (σ.σ. ο μεγαλύτερος εργολάβος αμυντικών έργων της χώρας), για να δημιουργήσει ένα σύστημα τεχνητής νοημοσύνης, το οποίο θα μπορεί να αναλύσει τη συμπεριφορά των ανθρώπων σε βίντεο κλειστών κυκλωμάτων βιντεοεπιτήρησης (CCTV), ανακαλύπτοντας σημάδια ότι κάποιο άτομο είναι έτοιμο να διαπράξει μια τρομοκρατική πράξη.

Μόλις ολοκληρωθεί, το εν λόγω σύστημα θα χρησιμοποιηθεί για να προβλέψει "συμβάντα ασφαλείας", ώστε η αστυνομία ή ο στρατός να μπορεί να αναπτυχθεί στην περιοχή εκ των προτέρων.

Ειδικοί των ανθρωπίνων δικαιωμάτων στην ψηφιακή εποχή, προειδοποιούν ότι η χρήση τεχνητής νοημοσύνης με αυτόν τον τρόπο θα μπορούσε να είναι ιδιαίτερα επικίνδυνη, επισημαίνοντας ότι η εξαγωγή γενικευμένων συμπερασμάτων από τόσο περιορισμένα δεδομένα δημιουργεί τεράστια προβλήματα για αθώους ανθρώπους.

«Οι πρακτικές αυτές δε διαφέρουν από τις θεωρίες περί φρενολογίας το 1800, οι οποίες έχουν καταρριφθεί.

Το σύστημα αυτό καταδεικνύει τους αυθαίρετους και παράλογους συσχετισμούς που μπορούν να εντοπίσουν οι αλγόριθμοι, η τεχνητή νοημοσύνη (AI) και η μηχανική μάθηση (machine learning), όταν χρησιμοποιούνται σε υπερβολικά μικρά σύνολα δεδομένων.

Γι’ αυτό δεν ευθύνονται οι τεχνολογίες, αλλά η εφαρμογή πολύπλοκων συστημάτων σε ακατάλληλα πλαίσια», σημειώνει ο Δρ. Richard Tynan του Privacy International.:

Η διαμάχη σχετικά με την αξιοποίηση – και φυσικά με ποιους όρους – αλγορίθμων σε τέτοιες περιπτώσεις είναι πιο έντονη από ποτέ σε αρκετές χώρες, συμπεριλαμβανομένων, φυσικά, των ΗΠΑ, όπου ήδη η χρήση τους είναι εκτεταμένη.

Το ερώτημα που εγείρεται αναφορικά με την αξιοπιστία των αποτελεσμάτων τέτοιων συστημάτων έχει, πέρα από ηθική πτυχή, και μία καθαρά πρακτική.

Για παράδειγμα, μια μελέτη από το ProPublica διαπίστωσε ότι ένας αλγόριθμος που δημιουργήθηκε στις ΗΠΑ για να προβλέπει πιθανούς υπότροπους εγκληματιών, εμφάνιζε αποτελέσματα «με προκαταλήψεις», καθώς η πρόβλεψη του κινδύνου ήταν πολύ μεγαλύτερη για τους Αφροαμερικανούς από ό,τι για τους Καυκάσιους.

Όταν εξετάστηκαν περαιτέρω τα αποτελέσματα, η έρευνα έδειξε πως υπήρχε μία ξεκάθαρη φυλετική ανισότητα: το λογισμικό ήταν πιο πιθανό να χαρακτηρίσει εσφαλμένα έναν μαύρο κατηγορούμενο ως μελλοντικό εγκληματία σε σχεδόν διπλάσιο ποσοστό από ό,τι έναν λευκό.

Πηγές: theintercept.com, thestack.com, telegraph.co.uk